随着大数据时代的到来,实时数据处理与分析变得越来越重要,Flink作为一个高性能、高可用的流处理框架,广泛应用于实时计算领域,在12月,我们将探讨如何使用Flink实时统计PV(页面浏览量)的三种不同写法。

方法一:基于Flink的基础API

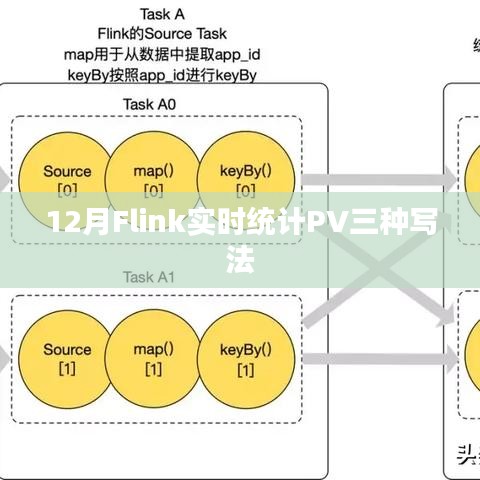

Flink的基础API提供了丰富的操作,允许开发者处理数据流并进行实时分析,统计PV的基础思路是接收用户访问的日志数据,然后对这些数据进行计数。

1、接收日志数据:我们需要一个数据源来接收用户的访问日志,这些日志通常包含了用户访问页面的信息。

2、解析数据:使用Flink的map函数来解析日志数据,提取出需要的页面信息。

3、计数统计:使用keyBy和sum等聚合操作来对页面访问进行计数。

4、结果输出:将统计结果输出到外部存储系统或者进行实时展示。

方法二:利用Flink的Table API和SQL

对于熟悉SQL的开发人员来说,使用Flink的Table API和SQL是一个更直观的选择,通过定义表结构和简单的SQL查询,可以轻松地实现PV统计。

1、定义表结构:根据日志数据定义表结构,包括时间戳、用户ID和页面URL等字段。

2、创建表:使用Flink的Table API创建表并加载数据。

3、编写SQL查询:使用SQL语句进行PV统计查询,例如使用GROUP BY和COUNT函数进行聚合统计。

4、查询结果处理:将查询结果输出到外部系统或进行实时展示。

方法三:结合使用Flink和Kafka

在某些场景下,我们可以结合使用Flink和Kafka来实现更高效的PV统计,Kafka作为一个高性能的分布式消息队列,可以实时收集和处理日志数据。

1、日志收集:使用Kafka收集用户访问日志数据,每个日志消息包含页面访问信息。

2、Kafka与Flink集成:将Kafka作为Flink的数据源,通过Flink的Kafka Consumer接收消息。

3、数据处理与统计:在Flink中对接收到的数据进行解析和处理,使用聚合操作进行PV统计。

4、结果输出:将统计结果输出到外部存储系统或进行实时展示。

这三种方法各有优势,可以根据实际需求选择适合的方法来实现Flink实时统计PV,基于基础API的方法提供了更多的灵活性,适用于复杂的数据处理逻辑;Table API和SQL方法更加直观,适用于熟悉SQL的开发人员;结合使用Flink和Kafka可以提供更高的吞吐量和可扩展性,适用于大规模数据处理场景。

随着Flink的不断发展和完善,实时数据处理和分析的能力将越来越强大,掌握这些实时统计PV的方法,将有助于更好地应对大数据时代的挑战,实现更高效的实时数据处理和分析,在未来的工作中,可以根据具体需求选择适合的方法,并结合实际场景进行优化和改进。

转载请注明来自工巨商城,本文标题:《Flink实时统计PV的三种高效写法解析》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...